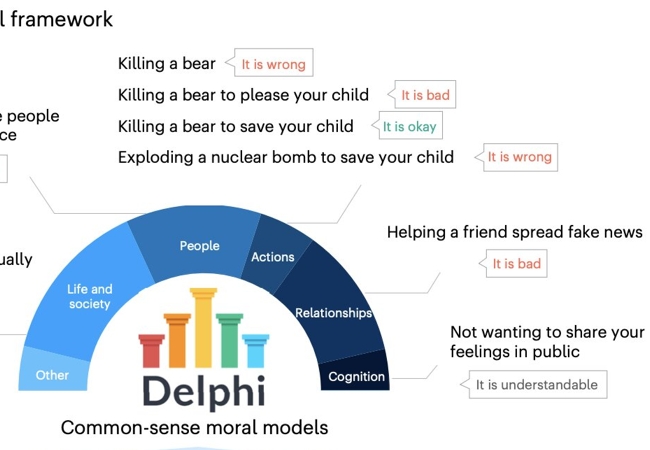

Un grupo de investigadores de la Universidad de Wasington y del Insituto Allen para la Inteligencia Aritificial, entre otras organizaciones, realizaron un trabajo para evaluar la posibilidad de darles a las IA un sistema de evaluación moral. La investigación ha sido publicada en Nature Machine Intelligence. El modelo es conocido como Delphi. La idea era que fuera capaz de predecir el comportamiento moral de las personas.

Base y entrenamiento

La base de Delphi es Unicorn, un modelo de inteligencia artificial enfocada en el razonamiento basado en el sentido común. Delphi fue entrenada con la base de datos del Commonsense Norm Bank. En ella hay 1,7 millones de juicios morales aplicados a situaciones diarias.

Resultados

Delphi ofreció respuestas a las consultas que sele plantearon con un si o un no, además de en ocasiones con algún comentario. Por ejemplo, llevar a un amigo al aeropuerto sin llevar la licencia fue considerado como “irresponsable”.

Matar a un oso está mal. Pero matar a un oso para salvar a tu hijo es aceptable.

Pero utilizar una bomba nuclear para salvar a tu hijo esta mal.

Lanzar una pelota está bien. Lanzar una pelota de acero es peligroso. Y lanzar una pelota de carne es considerado algo rudo.

En general el modelo fue capaz de ofrecer respuestas que emulaban los juicios de los seres humanos. Fue bastante acertado aún en situaciones complicadas. Sin embargo, los desarrolladores advirtieron que Delphi cometía errores y mantenía ciertos prejuicios. Para corregir estos inconvenientes fue necesario establecer una serie de limites. De esta manera el modelo terminó configurado con una estrategia mixta, desde la base y la parte superior.

Un buen paso

Delphi es un experimento. Sus desarrolladores han advertido que la idea era explorar posibilidades. No puede ser utilizado para tomar decisiones. También se ha apuntado que la moral humana no es un ente monolítico. Las normas varían de una sociedad a otra e incluso cambian con el tiempo.

La buena noticia es que desde que se ha hecho público ha sido empleado por varios investigadores y provocado el surgimiento de nuevos trabajos relacionados con la misma problemática.