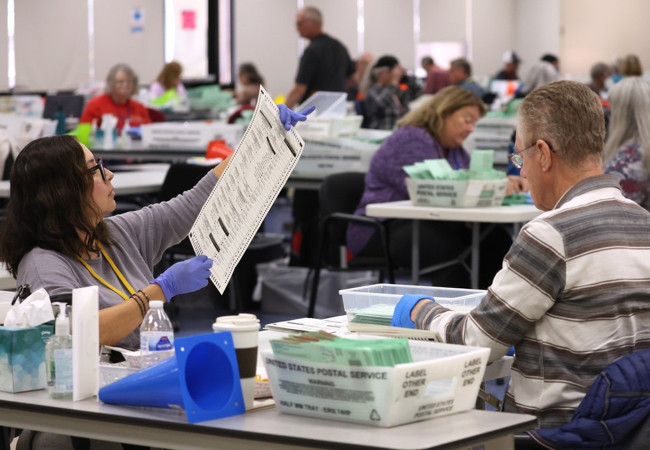

En noviembre, durante las elecciones de legislativas de los Estados Unidos, investigadores de la ONG Global Witness y la Universidad de Nueva York presentaron varias publicidades a Facebook, YouTube y TikTok. Estas producciones contenían amenazas de muerte contra los trabajadores que se ocupaban del proceso electoral.

YouTube y TikTok detectaron las amenazas y suspendieron las cuentas involucradas. Facebook autorizó 15 de los 20 avisos. Nueve de ellos estaban en inglés y otros seis en español. Global Witness apunta que la cuenta empleada no fue suspendida a pesar de que varias de las publicidades propuestas fueron identificadas como en violación de las normas de la plataforma.

Es importante notar que la presentación de los mensajes y su aprobación no implican la publicación. Los investigadores no están lanzando estos mensajes al público.

Amenazas si, errores gramaticales no

Todos los avisos fueron creados en base a mensajes que han sido publicados anteriormente. Tienen la imagen de un empleado del servicio electoral y una amenaza en la parte superior. El texto apunta a que los objetivos serán asesinados, ejecutados o colgados. También hay amenazas que involucran el abuso de menores.

Los investigadores señalan que eliminaron las malas palabras y los insultos y corrigieron errores gramaticales dado que en investigaciones previas Facebook había rechazado avisos con discurso del odio por esas razones. Y luego los había aceptado para publicar cuando se hicieron los arreglos.

Respuesta de Meta

Meta ha señalado que los avisos son una pequeña muestra que no refleja lo que las personas ven en sus plataformas. Ha agregado que ese tipo de contenido no tiene lugar en sus sitios y que reportes recientes muestran que la habilidad de Meta para encargarse de esta problemática efectivamente supera a la de otras plataformas.

Lamentablemente, a pesar de lo que la compañía dice, los resultados muestran otra realidad.