Hace un tiempo les contamos como un equipo de abogados había utilizado a ChatGPT para buscar casos de referencia en un juicio por daños contra una aerolínea. El resultado fueron varios precedentes que fueron presentados, pero luego demostraron ser invenciones de la inteligencia artificial.

Cuando lo que había sucedido quedó claro, se pidieron disculpas, pero de todos modos los involucrados estaban en grandísimos problemas.

Sanciones leves

Hace unos días un juez estableció multas de USD 5 mil para los abogados y la firma responsables de este papelón. Kevin Castel señaló que los abogados habían actuado de mala fe. Sin embargo, consideró que las disculpas y los pasos para reparar lo ocurrido hacían innecesario imponer sanciones más fuertes.

Tomando en cuenta el desastre producido podemos decir que se salvaron de una reprimenda mucho mayor.

Una puerta abierta a la IA

Lo más interesante de la resolución de Castel es la declaración que hace sobre el papel de las IA en el proceso judicial.

“Los avances tecnológicos son comunes y no hay nada intrínsecamente impropio en el uso de una herramienta de inteligencia artificial confiable como asistente. Sin embargo, las reglas actuales imponen un rol de curación en los abogados para asegurar la certeza de sus presentaciones”.

Esta parece contradecir la postura de un juez del estado de Texas, que anteriormente había señalado que los abogados no debían utilizar ChatGPT u otras IA generativas porque podían inventar hechos. Sin embargo, en ambos casos el problema parece ser el funcionamiento de los modelos actuales y su tendencia a alucinar. Así como también el abandono de la responsabilidad de los abogados.

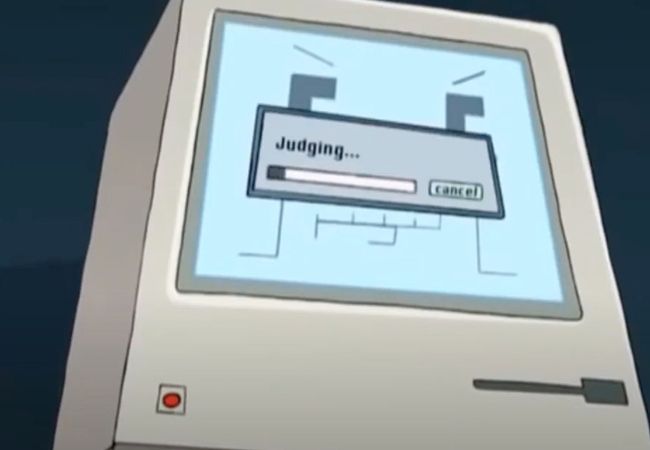

Imagen: Puramente ilustrativa, no tenemos evidencia de que el juez Castel sea un robot. Tampoco tenemos evidencia de lo contrario.