El desarrollo de los modelos generativos ha llevado a muchos a predecir el reemplazo de los seres humanos en una amplia variedad de ámbitos. Entre ellos en el de la programación. Hasta ahora las IA han demostrado ser muy efectivas a la hora de producir programas de poca complejidad, pero muy poco confiables cuando debían producir soluciones complejas.

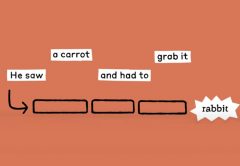

Un estudio publicado recientemente apunta a un problema que parecer repetirse con cierta asiduidad cuando las inteligencias artificiales programan. Alucinan nombres de paquetes. Los paquetes son, simplificando la definición, conjuntos de archivos empleados como recursos en un desarrollo.

Este comportamiento recuerda al observado en las tareas realizadas para firmas legales.

Alucinaciones

El trabajo fue realizado por las universidades de Texas, San Antonio, Oklahoma y Virginia Tech. Fue presentado en junio, por lo que no incluye las versiones más modernas de las IA. Un total de 16 modelos generativos fueron examinados.

Con estas herramientas se produjeron unos 576 mil fragmentos de código en Python y JavaScript. En los modelos comerciales se obtuvieron alucinaciones en el 5,2% de los casos, en los de código abierto en un 21,7%. De un total de 2,23 millones de paquetes creados, unos 440.445 fueron delirios de las IA.

Restricciones y calidad

Para reducir la posibilidad de que se produzcan alucinaciones los investigadores implementaron un esquema RAG, Este sistema combina la capacidad de las IA con una base de datos establecida. La idea era ofrecer una serie de paquetes y filtrar aquellos que podían ser inventados. Aunque esto redujo las alucinaciones produjo una caída de la calidad.

Grande no siempre es mejor

Otro detalle curioso es que los modelos más grandes tienden a ser más precisos. Pero al mismo tiempo son menos confiables. La razón es que los modelos pequeños evitan responder a consignas que los superan, mientras que los grandes a menudo dan respuestas plausibles pero erróneas. ¡Les falta humildad!

En el caso de ChatGPT, la versión 4 tendía a responder casi cualquier cosa. Mientras que versiones anteriores podían evitar dar una respuesta.

Aún con supervisión humana

Por otro lado, los investigadores descubrieron que los seres humanos clasifican como correctas las respuestas erróneas en hasta un 40% de los casos.