Seth Larson es el encargado de seguridad de la fundación Python. Entre sus tareas se encuentra la evaluación de los reportes de vulnerabilidades vinculadas a los proyectos Cpython, urllib3 y pip. También es consultado a menudo en relación a otros proyectos de código abierto.

Hace unos día Larson advirtió que los modelos de IA generativos están produciendo de forma repetitiva una enorme cantidad de reportes de seguridad de baja calidad. Muchos de ellos parecen ser legítimos a primera vista, por lo que los encargados de los proyectos necesitan revisarlos. Sin embargo, luego se comprueba que son solo alucinaciones.

Larson no responsabiliza solo a la inteligencia artificial. Las personas que utilizan las herramientas no revisan correctamente la información generada.

La era del Slop

Los reportes que hacen perder el tiempo a quienes mantienen los proyectos producen confusión, estrés y frustración. La situación empeora porque en la mayoría de las ocasiones los problemas de seguridad suponen un alto nivel de secreto y por tanto aislamiento.

Aún cuando no sea la intención, explica Larson, los reportes de baja calidad deberían ser tratados como acciones maliciosas. Una de las razones es que perjudican el trabajo en seguridad.

Cabe recordar que el término slop fue, junto a brainrot, palabra destacada por la Universidad de Oxford para 2024.

Brainrot es la palabra del año para la Universidad de Oxford

Sugerencias

Larson señala que las plataformas deberían crear sistema para evitar la creación de reportes automatizados o abusivos. Permitir que los reportes sean públicos sin dar detalles específicos. La idea es exponer a quienes actúan con descuido. También se deberían restringir las opciones de los nuevos usuarios.

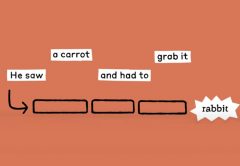

Los usuarios no deberían usar a las IA para detectar vulnerabilidades. Los sistemas actuales no entienden el código. Para encontrar vulnerabilidades también deben entenderse conceptos humanos tales como intención, uso común y contexto. No enviar reportes que no han sido revisados por seres humanos.

Más detalles sobre el problema y las posibles soluciones pueden consultarse en la publicación original.