Las compañías desarrolladoras de inteligencia artificial tienen en su gran mayoría un gran objetivo final, producir una inteligencia artificial general. El término no tiene una definición única y clara. A menudo las empresas cambian los términos según lo que esperan conseguir y las dificultades que encuentran.

Meta ha adoptado una estrategia de código abierto. Una parte de ese compromiso supone hacer que la IAG esté disponible de forma pública. Sin embargo, más recientemente la compañía ha señalado que existen dos tipos de sistemas que no piensa distribuir. Estos son los que se califican como de alto riesgo y riesgo crítico.

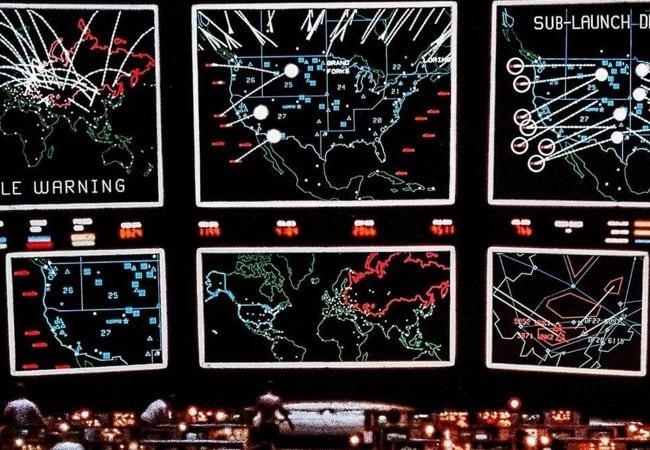

Los sistemas de riesgo alto y crítico están por lo general asociados al manejo de la seguridad informática, trabajo con químicos y la producción de armas biológicas. Los de riesgo crítico se distinguen por producir resultados catastróficos que no pueden ser mitigados por el contexto de su implementación.

Meta y el sentido común

Meta no ofrece una lista extensa de ejemplos. Las referencias que realiza consideran lo que se cree son las amenazas más inmediatas y probables. Así pues, nada de nubes de micro robots arrasando el planeta. Aún no.

Otra curiosidad es que la compañía no ha establecido un sistema empírico de clasificación de riesgo. En cambio confía en la opinión de investigadores propios y externos. La empresa argumenta que no existe aún conocimiento suficiente en el campo como para producir métricas confiables.

Medidas

Cuando un sistema es de alto riesgo la empresa limita su acceso y no lo publica hasta que se hayan desarrollado las medidas de protección adecuadas. El objetivo es reducir el riesgo al nivel moderado. Con los sistemas de riesgo crítico la empresa aplica medidas para que no se filtre al exterior. Al mismo tiempo congela su desarrollo hasta que pueda bajarse el nivel de riesgo.