OpenAI anunció GPT-4 Omni (GPT-4o) como el nuevo modelo de lenguaje multimodal insignia de la compañía; fue el 13 de mayo pasado, durante el Spring Updates de la empresa. Como parte del evento, OpenAI lanzó varios videos que demuestran la respuesta de voz intuitiva y las capacidades de respuesta e interacción renovadas del modelo.

GPT-4o es la tercera versión importante de OpenAI de su popular modelo multimodal grande, GPT-4, que amplía sus capacidades, principalmente, con las características de Visión.

El modelo recién lanzado es capaz de hablar, ver e interactuar con el usuario de forma integrada y fluida, más que las versiones anteriores cuando se utiliza la interfaz ChatGPT. En este informe, analizaremos qué nos trae de nuevo GPT-4o, en qué se diferencia de los modelos anteriores, su rendimiento y casos de uso.

Autor: Claudio Bottini

Interacción más natural

En el anuncio de GPT-4o, OpenAI centró la capacidad del modelo para una “interacción persona-computadora mucho más natural”.

La O en el nombre del nuevo modelo significa Omni (“todo” o “universal”), y esta vez el nombre no es solo una estrategia de marketing, sino más bien una referencia a sus múltiples modalidades para texto, visión y audio.

El modelo GPT-4o marca una nueva evolución para GPT-4 LLM que OpenAI lanzó por primera vez en marzo de 2023. Esta tampoco es la primera actualización para GPT-4, ya que el modelo recibió un impulso por primera vez en noviembre de 2023, con el debut del GPT-4 Turbo.

Recordemos que GPT significa Transformador Preentrenado Generativo. Un modelo de la gama transformer es un elemento de la IA generativa, ya que proporciona una arquitectura de red neuronal que es capaz de comprender y generar nuevos resultados.

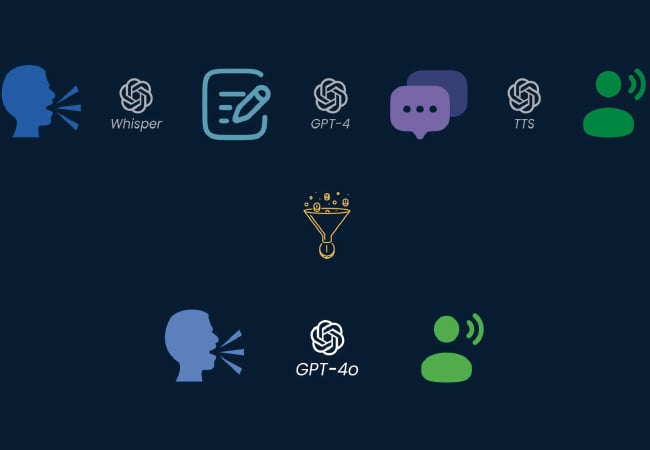

La potencia y la velocidad de GPT-4o provienen de ser un único modelo que maneja múltiples modalidades. Las versiones anteriores utilizaban múltiples modelos de propósito único (estaba la versión voz a texto, otra para texto a voz, una más para texto a imagen) y creaban una experiencia separada, lo que obligaba a hacer un cambio entre modelos para diferentes tareas complementarias.

En comparación con la versión anterior, OpenAI afirma que es dos veces más rápido, un 50% más barato tanto en tokens de entrada (5 dólares por millón) como en tokens de salida (15 dólares por millón), y tiene un límite de velocidad cinco veces mayor (hasta 10 millones de tokens por minuto).

Además, GPT-4o tiene una ventana de contexto de 128K y una fecha límite de conocimiento de octubre de 2023.

Algunas de las nuevas capacidades están actualmente disponibles en línea a través de ChatGPT, de la aplicación ChatGPT en dispositivos de escritorio y móviles, de la API OpenAI y de Microsoft Azure.

GPT-4o va más allá de lo que proporcionó GPT-4 Turbo en términos de capacidades y rendimiento. Como fue el caso de sus predecesores GPT-4, GPT-4o se puede utilizar para generación de texto, como resúmenes y preguntas y respuestas basadas en conocimientos. El modelo también es capaz de razonar, resolver problemas matemáticos complejos y codificar.

El modelo GPT-4o introduce una nueva respuesta rápida de entrada de audio que, según OpenAI, es similar a la de un humano, con un tiempo de respuesta promedio de 320 milisegundos. También puede responder con una voz generada por IA que suena humana (realmente, muy humana…).

En vez de tener múltiples modelos separados que entienden audio, imágenes

(a lo que OpenAI se refiere como visión) y texto, GPT-4o combina esas modalidades en un solo modelo. Por lo tanto, puede comprender cualquier combinación de entrada de texto, imagen y audio, y responder con salidas en cualquiera de esas formas.

La promesa de GPT-4o y su capacidad de respuesta multimodal de audio de alta velocidad permiten al modelo participar en interacciones más naturales e intuitivas con los usuarios.

¿Qué puede hacer GPT-4o?

Desde el momento de su lanzamiento, GPT-4o es el más capaz de todos los modelos OpenAI en términos de funcionalidad y rendimiento.

Las características de GPT-4o van desde mejoras a funcionalidades ya existentes, inclusión de funciones que eran premium como parte del modelo básico y nuevas aptitudes, que incluyen:

- Interacciones en tiempo real. El modelo GPT-4o puede entablar conversaciones verbales en tiempo real sin retrasos notables.

- Preguntas y respuestas basadas en el conocimiento. Como sucedió con todos los modelos GPT-4 anteriores, GPT-4o ha sido entrenado con una base de conocimientos y es capaz de responder preguntas.

- Resumen y generación de textos. Al igual que sus predecesores, GPT-4o puede ejecutar tareas clásicas de un LLM, incluido el resumen y la generación de texto.

- Razonamiento y generación multimodal. GPT-4o integra texto, voz y visión en un solo modelo, lo que le permite procesar y responder a una combinación de tipos de datos. El modelo puede comprender audio, imágenes y texto a la misma velocidad. También puede generar respuestas a través de audio, imágenes y texto.

- Procesamiento del lenguaje y del audio. GPT-4o tiene capacidades avanzadas para manejar más de 50 idiomas diferentes de forma compleja, lo que mejora notablemente las capacidades de traducción, pero en particular, la de comprender instrucciones en cualquiera de ellos con la misma confiabilidad.

- Análisis de los sentimientos. El modelo comprende la opinión del usuario en diferentes modalidades de texto, audio y video.

- Matiz de voz. GPT-4o puede generar discurso con matices emocionales. Esto lo hace eficaz para aplicaciones que requieren una comunicación sensible y matizada.

- Análisis de contenidos de audio. El modelo puede generar y comprender el lenguaje hablado, lo cual se puede aplicar en sistemas activados por voz, análisis de contenido de audio y narración interactiva.

- Traducción en tiempo real. Las capacidades multimodales de GPT-4o pueden permitir la traducción en tiempo real de un idioma a otro, casi sin demoras significativas para el oído humano.

- Comprensión y visión de la imagen. El modelo puede analizar imágenes y videos, lo que permite a los usuarios cargar contenido visual que GPT-4o comprenderá, podrá explicar y analizar.

- Análisis de los datos. Las capacidades de visión y razonamiento permiten a los usuarios usarlo para analizar los datos contenidos en gráficos de datos. GPT-4o también puede crear gráficos de datos basados en análisis o indicaciones.

- Cargas de archivos. Más allá del límite de conocimiento, GPT-4o admite la carga de archivos, lo que permite analizar datos específicos.

- Memoria y conciencia contextual. GPT-4o puede recordar interacciones anteriores y mantener el contexto durante conversaciones más largas. Es lo que los desarrolladores de OpenAi llaman como “darle más memoria al modelo”.

- Gran ventana contextual. Con una ventana de contexto que admite hasta 128.000 tokens, GPT-4o puede mantener la coherencia en conversaciones o documentos más largos. Esto lo vuelve adecuado para análisis detallados, donde la interacción de preguntas y reformulaciones requiere mantener el “hilo” de la conversación de forma mucho más extensa.

- Reducción de las alucinaciones y mayor seguridad. El modelo está diseñado para minimizar la generación de información incorrecta o engañosa. GPT-4o incluye protocolos de seguridad mejorados para garantizar que las salidas sean apropiadas y seguras para los usuarios.

Sigue leyendo este informe en RedUSERS PREMIUM

También te puede interesar:

LM STUDIO PRIMEROS PASOS

En el mundo actual, donde la tecnología impulsa la economía global y redefine las relaciones internacionales, la producción de microchips se ha convertido en un campo de batalla crucial. En el epicentro de esta contienda, se encuentran dos gigantes: China y Estados Unidos.

En un escenario marcado por tensiones geopolíticas y rivalidades comerciales, la competencia por el dominio en la fabricación de chips no solo tiene implicaciones económicas, sino también estratégicas y de seguridad nacional.

En este Informe USERS, se explora el complejo entramado de intereses y desafíos que caracterizan la guerra en la producción de chips, examinando cómo estas potencias mundiales luchan por la supremacía en un sector fundamental para la innovación tecnológica y el desarrollo industrial.

Cada mes, lanzamos 2 ebooks USERS, en ellos tratamos en profundidad el tema abordado. En cada ebook, nuestros EXPERTOS vuelcan todos sus conocimientos con el objetivo de brindar una experiencia de capacitación satisfactoria para nuestros lectores.

Lee lo que quieras, donde vayas, por una mínima cuota mensual: SUSCRIBETE!