El modelo o3-Mini de OpenAI marca un hito en la evolución de la inteligencia artificial, enfocándose en el razonamiento lógico y la eficiencia computacional. Su diseño optimizado mejora la velocidad de respuesta y reduce el consumo de recursos, facilitando su aplicación en diversos entornos.

Este resumen detalla sus características, mejoras y su comparación con otros modelos de IA

Autor: Osvaldo González Lauge

Origen y evolución de la serie O

La serie O de OpenAI nació para superar las limitaciones de los modelos previos de IA, especialmente en razonamiento estructurado y toma de decisiones complejas. o3-Mini se posiciona como la versión optimizada del modelo o3, manteniendo su capacidad analítica pero con menor demanda de recursos computacionales.

Su desarrollo fue influenciado por las versiones anteriores, o1 y o1-Mini, que mostraron deficiencias en precisión y retención de contexto en interacciones prolongadas. OpenAI respondió con o3, que mejoró la arquitectura de atención y la interpretación contextual, dando paso a o3-Mini, diseñado para entornos con restricciones técnicas sin perder capacidades de inferencia avanzada.

El desarrollo del modelo o3-mini se sustenta en los avances logrados con sus predecesores, particularmente o1 y o1-mini. Aunque no se introdujo un modelo denominado “o2” debido a cuestiones de marca y continuidad en la nomenclatura, la evolución entre estas versiones muestra mejoras sustanciales en rendimiento y efi ciencia.

Arquitectura y mejoras funcionales

o3-Mini incorpora innovaciones como la alineación deliberativa, una estrategia de entrenamiento que prioriza la seguridad y coherencia de las respuestas, minimizando la generación de contenido sesgado o inadecuado. Además, su diseño optimiza el uso de memoria mediante técnicas de cuantización y poda de parámetros, logrando una mayor eficiencia computacional.

Su entrenamiento con conjuntos de datos diversificados le permite adaptarse a múltiples dominios, como programación, ciencia de datos e investigación académica. En comparación con otros modelos, muestra una interpretación más precisa de estructuras lingüísticas complejas y un razonamiento más estructurado en problemas matemáticos y algoritmos.

OpenAI diseñó esta serie para equilibrar rendimiento y eficiencia, permitiendo su integración en entornos donde la velocidad y la coherencia en el procesamiento de información compleja son fundamentales.

Comparación con otros modelos

Frente a GPT-4o Mini y Claude 3 Haiku, o3-Mini destaca en razonamiento lógico y generación de código, superando a sus competidores en benchmarks como MMLU y BBH, con una ventaja del 1.4% y 3.7%, respectivamente.

Su precisión en generación de código también es superior, alcanzando hasta 5.6 puntos porcentuales por encima de Claude Haiku en pruebas como HumanEval y MBPP. Además, su latencia es un 10% menor que la de GPT-4o Mini y un 20% menor que la de Claude Haiku, con un menor consumo de memoria.

No obstante, en generación creativa y narrativa, Claude Haiku se posiciona como una mejor alternativa, lo que refleja diferencias en el enfoque de entrenamiento de cada sistema.

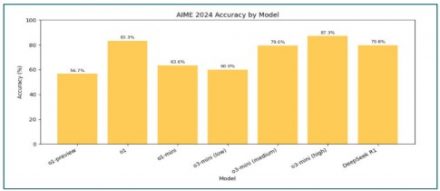

Rendimiento en problemas de competencia de matemáticas

Integración y aplicación empresarial

o3-Mini es compatible con APIs RESTful, GraphQL y WebSockets, permitiendo su fácil integración en sistemas existentes. Su interoperabilidad con TensorFlow y PyTorch lo hace ideal para proyectos de investigación y desarrollo en inteligencia artificial.

En el ámbito empresarial, se ha implementado en sistemas CRM y ERP, así como en herramientas de productividad como Microsoft 365 y Google Workspace. También es compatible con plataformas de automatización como Zapier y Make, facilitando la creación de flujos de trabajo sin necesidad de programación avanzada.

A pesar de sus ventajas, enfrenta desafíos en compatibilidad con arquitecturas legadas y optimización de costos en entornos de alta demanda. Su evolución futura podría abordar estos aspectos, consolidando su rol en la inteligencia artificial aplicada al razonamiento y la toma de decisiones.

En términos de eficiencia, O3-Mini ha sido optimizado para reducir la latencia y el consumo de recursos computacionales. Se comparó la latencia promedio de respuesta y el uso de memoria en condiciones controladas.

Encuentra la versión completa de la publicación en la que se basa este resumen, con todos los detalles técnicos en RedUSERS PREMIUM

También te puede interesar:

DEEP RESEARCH DE OPEN AI BUSQUEDAS AVANZADAS EN INTERNET

Deep Research de OpenAI es una herramienta avanzada de inteligencia artificial diseñada para optimizar la investigación automatizada en internet. A diferencia de las capacidades tradicionales de ChatGPT, este sistema permite realizar búsquedas extensivas, analizar información y generar informes estructurados en menos tiempo.

Su desarrollo promete cambiar la forma en que se accede y sintetiza el conocimiento en diversas disciplinas.

Lee todo lo que quieras, donde vayas, contenidos exclusivos por una mínima cuota mensual. Solo en RedUSERS PREMIUM: SUSCRIBETE!